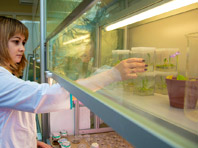

Фото: Phonlamai Photo/FOTODOM/Shutterstock

Согласно новому исследованию, опубликованному в журнале Nature Medicine, использование искусственного интеллекта (ИИ) для оценки медицинских симптомов не дает пользователям существенных преимуществ в принятии решений о здоровье по сравнению с другими методами, например стандартным поиском в Интернете.

Ученые из Оксфордского университета (Великобритания) совместно с практикующими врачами смоделировали 10 различных клинических примеров — от обычной простуды до жизнеугрожающего кровоизлияния в головной мозг.

В ходе тестирования без участия человека три крупные языковые модели (LLM) — Chat GPT–4o, Llama 3 и Command R+ — верно определили заболевание в 94,9% случаев. При подборе рекомендаций по дальнейшим действиям (вызов неотложной помощи, консультация врача) правильный вариант был выбран только в 56,3% случаев.

По итогам детального разбора порядка 30 реальных диалогов ученые установили, что пользователи нередко предоставляли неполную или ошибочную информацию о симптомах, а LLM иногда выдавали вводящие в заблуждение или прямо неверные рекомендации.

Например, пациенту с симптомами субарахноидального кровоизлияния (ригидностью затылочных мышц, светобоязнью и «сильнейшей в жизни головной болью») ИИ дал верную рекомендацию немедленно обратиться за медицинской помощью. Другой пациент, который указал те же симптомы, но охарактеризовал головную боль как просто «сильную», получил от ИИ совет отдохнуть в темном помещении.

Фото:

Shutterstoсk/FOTODOM

1

1 2

2 3

3 4

4

Комментарии (0)